在知乎上看到一个类似标题所述的问题,就搜索了一下相关信息,整体看,虽然美帝禁售了A100,但是国内目前并不缺少这类训练资源。从英伟达销售数据估算,这近3年至少在中国销售了A100、V100级别的训练卡31.5万块。中国移动21年集采中也有约1万块左右的训练卡,中国电信训练和推理的服务器没有完全分开,20年2767台,22年1268台服务器,估计其中1/3是训练服务器,22年训练卡可能达到3200块。

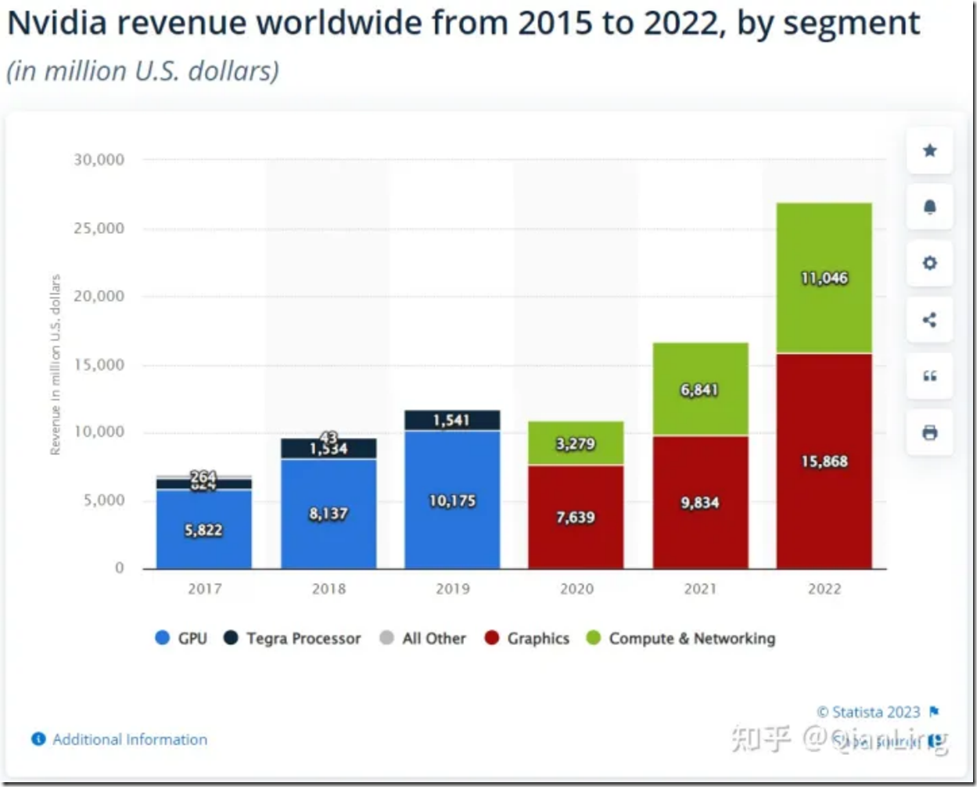

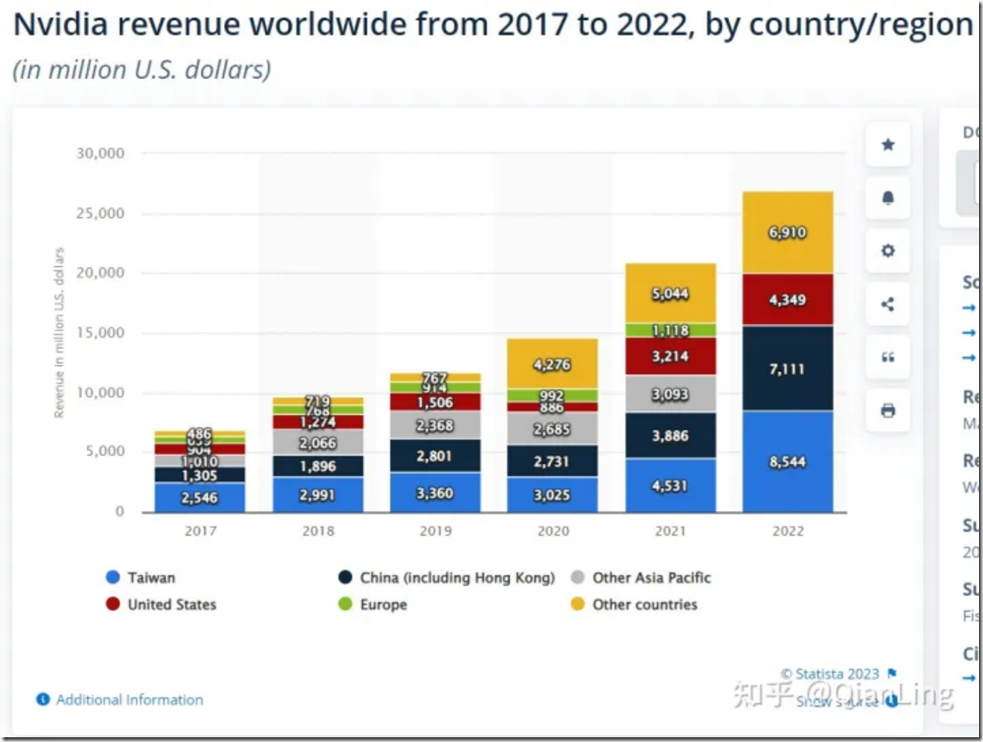

美帝22年禁售了A100和H100,据说英伟达22年Q3影响收入达到4亿美元(随后有了阉割版本A800,买卖继续了)。如果考虑下面第二个图的总金额看,预计全年在中国的销量可以达到16亿美金,一个A100/V100的零售价大约6万人民币(参考JD价),那么16亿美金最多可以采购18万张V100+训练卡。考虑到21年的销售量是22年的一半左右,那么21年中国最多有9万张V100训练卡,以此类推,20年估计最多4.5万张训练卡。

这样看来,国内预计最多有31.5万块V100级别训练卡。虽然这些卡会分布在很多企业中,但是拥有1500+张V100卡的大型企业也不是个别。训练GPT3,如果用1000张A100卡,可以缩短到1个月。达摩院PLUG 270亿参数,用了128张GPU。Meta AI用了992块英伟达A100 GPU(80GB)训练OPT-175B(16张V100也能部署OPT预训练)

所以说,算力中国有很多,不用集中全国之力,很多企业自己就可以干大模型。

下面这段是ChatGPT回答的:

训练1000亿参数的大模型,需要多少GPU?

这取决于模型的复杂度,但通常情况下,训练1000亿参数的大型模型所需要的GPU数量在数百台以上。

训练ChatGPT模型用了多少个GPU卡?

ChatGPT模型使用了16张Tesla V100 GPU卡,每张GPU卡有32 GB的内存。

GPU Market Share: Who Dominates The GPU Market in 2022?

https://www.nvidia.com/en-us/data-center/a100/

NVIDIA Ampere Architecture In-Depth | NVIDIA Technical Blog

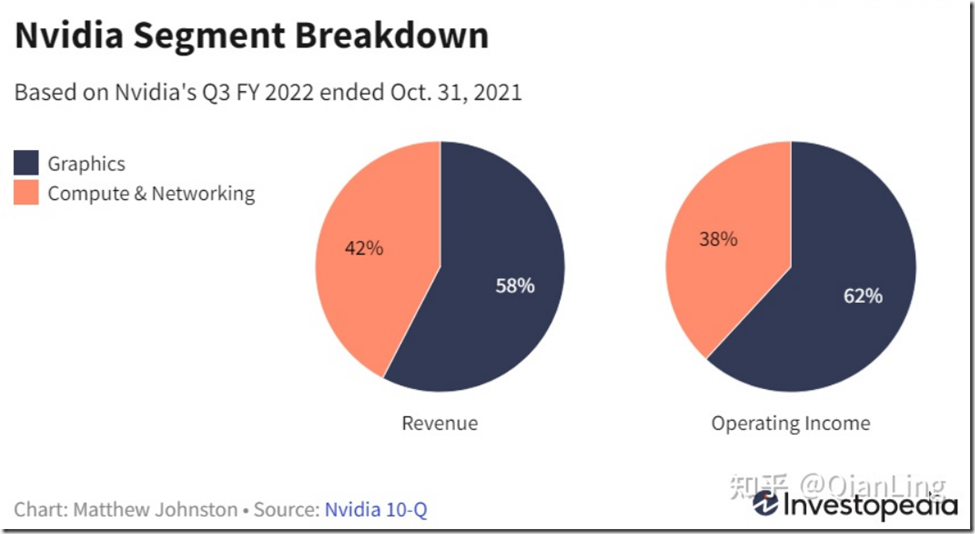

How Nvidia Makes Money: Graphics Segment Generates the Most Revenue

https://www.investopedia.com/nvidia-q3-fy2022-earnings-report-recap-5210022

NVIDIA发布2021财年第四季度及全年财务报告 – NVIDIA 英伟达中国官方博客

https://www.hpcwire.com/2022/09/01/us-bars-nvidia-and-amd-from-selling-top-gpus-into-china/

量子位:Meta复刻GPT-3“背刺”OpenAI,完整模型权重及训练代码全公开

量子位:达摩院用128张GPU烧出“中文版GPT-3”,我试了下,这文风不是开往幼儿园的车…

中国移动 AI 服务器集采(标包一、三)中标结果:中兴 1.26 亿元、浪潮 9113 万元、新华三 4832 万元

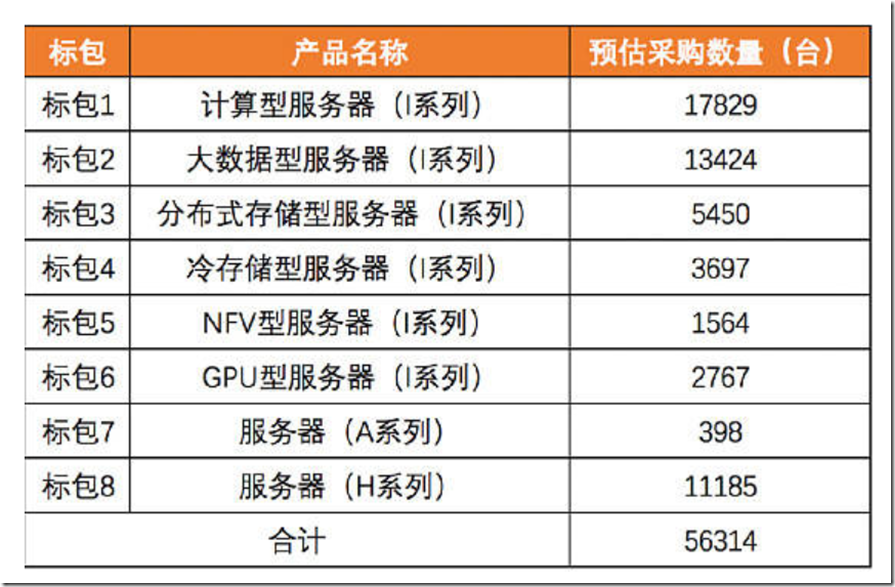

附录1:中国移动和中国电信GPU服务器集采

https://cloud.tencent.com/developer/article/1958881 一共4400台服务器,训练型服务器是1327台,大约10616块训练卡

中国电信22年集采结果,其中1268台GPU服务器

中国电信20年集采结果,其中2767台GPU服务器